大數據分析挖掘已成為驅動現代商業決策與科學發現的核心引擎,而數據處理技術則是其堅實的地基。本課程旨在系統性地傳授大數據處理的關鍵技術與實戰方法,為學員構建從數據采集到價值提取的完整能力鏈條。

一、 課程核心要點

- 核心理念建立:深刻理解大數據4V特性(Volume, Velocity, Variety, Veracity)對數據處理提出的挑戰與要求,樹立“數據質量是分析生命線”的工程化思維。

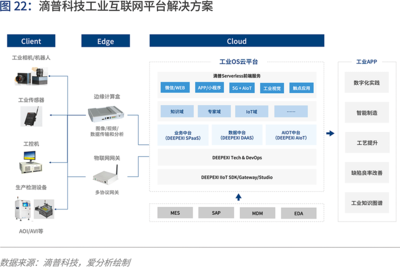

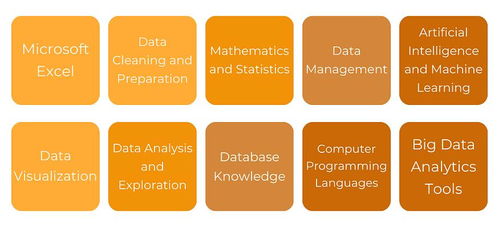

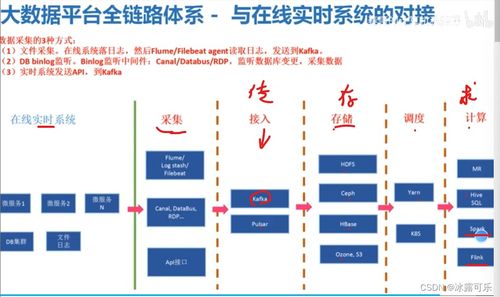

- 技術棧全景掌握:系統學習批處理與流處理兩大范式,掌握以Hadoop、Spark、Flink為代表的核心開源生態工具。

- 全流程技能覆蓋:從數據采集與集成、存儲與管理、清洗與轉換,到最終的聚合與準備,掌握每個環節的主流技術與最佳實踐。

- 性能與優化意識:理解分布式計算原理,學習數據傾斜處理、存儲格式優化、計算資源調優等關鍵性能提升技術。

- 實戰能力培養:通過基于真實場景或高仿真數據集的項目練習,強化學員解決復雜數據問題的綜合能力。

二、 詳細課程大綱

模塊一:大數據處理基礎與生態概述

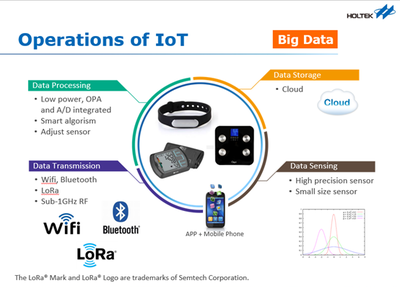

- 大數據概念、挑戰與典型應用場景

- 分布式系統基礎概念(CAP定理、容錯、伸縮性)

- Hadoop生態系統簡介(HDFS, YARN)

- 數據處理范式:批處理 vs. 流處理 vs. 交互式查詢

模塊二:大數據采集與集成

- 數據來源:日志文件、數據庫、傳感器、第三方API等

- 批量采集工具:Sqoop, DataX

- 實時采集工具:Flume, Kafka(作為消息隊列與數據管道)

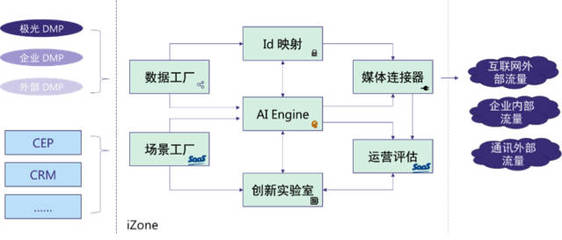

- 數據集成策略與數據湖/倉庫入口建設

模塊三:分布式存儲與數據管理

- HDFS原理、架構與操作

- 列式存儲:HBase原理與基本使用

- 數據倉庫概念:Hive表設計、分區與分桶

- 云原生存儲簡介(如AWS S3, Azure Blob Storage)

模塊四:批處理核心技術 - Apache Spark

- Spark核心概念:RDD、DataFrame/Dataset

- Spark SQL:結構化數據查詢與處理

- Spark Core:Transformation與Action操作,寬窄依賴與執行計劃

- 性能調優:內存管理、分區策略、廣播變量與累加器

模塊五:流處理核心技術

- 流處理概念與架構(Lambda/Kappa架構)

- Apache Spark Streaming:微批處理模型

- Apache Flink:真正的流處理引擎,時間語義與窗口操作

- Kafka Streams:輕量級流處理庫應用

模塊六:數據清洗、轉換與質量保障

- 數據清洗:處理缺失值、異常值、重復值

- 數據轉換:規范化、標準化、編碼、特征工程基礎

- 使用Spark、Pandas等工具進行數據清洗與轉換實戰

- 數據質量維度與監控:準確性、完整性、一致性、時效性

模塊七:數據處理工作流與調度

- 工作流編排工具:Apache Airflow, Oozie

- 任務依賴管理、定時調度與監控告警

- 構建端到端、可維護的數據處理流水線

模塊八:云平臺數據處理實戰與趨勢

- 主流云平臺(AWS EMR, Azure HDInsight, Google Dataproc)上的數據處理服務

- 無服務器數據處理(如AWS Glue, Azure Data Factory)

- 當前趨勢探討:湖倉一體(Lakehouse)、實時數倉、數據處理自動化

三、 教學方法與預期成果

課程將采用“理論講解-演示-實驗-項目”四步法。學員在完成課程后,將能夠:

- 獨立設計并實施針對特定業務需求的大數據處理方案;

- 熟練運用Spark、Flink等核心框架進行批量和實時數據處理開發;

- 構建健壯、高效、可維護的數據管道,為上層分析與挖掘提供高質量數據底座;

- 具備解決實際生產中常見數據問題(如性能瓶頸、數據傾斜)的能力。

數據處理技術是大數據價值煉金術的第一步。本課程大綱旨在構建一個既全面又深入的技能體系,幫助學員筑牢根基,從容應對海量數據的挑戰,并為其在大數據分析與數據科學領域的深入發展鋪平道路。